NN和2NN工作机制

1. NN和2NN工作机制

思考:NameNode中的元数据是存储在哪里的?或者为何需要2NN?

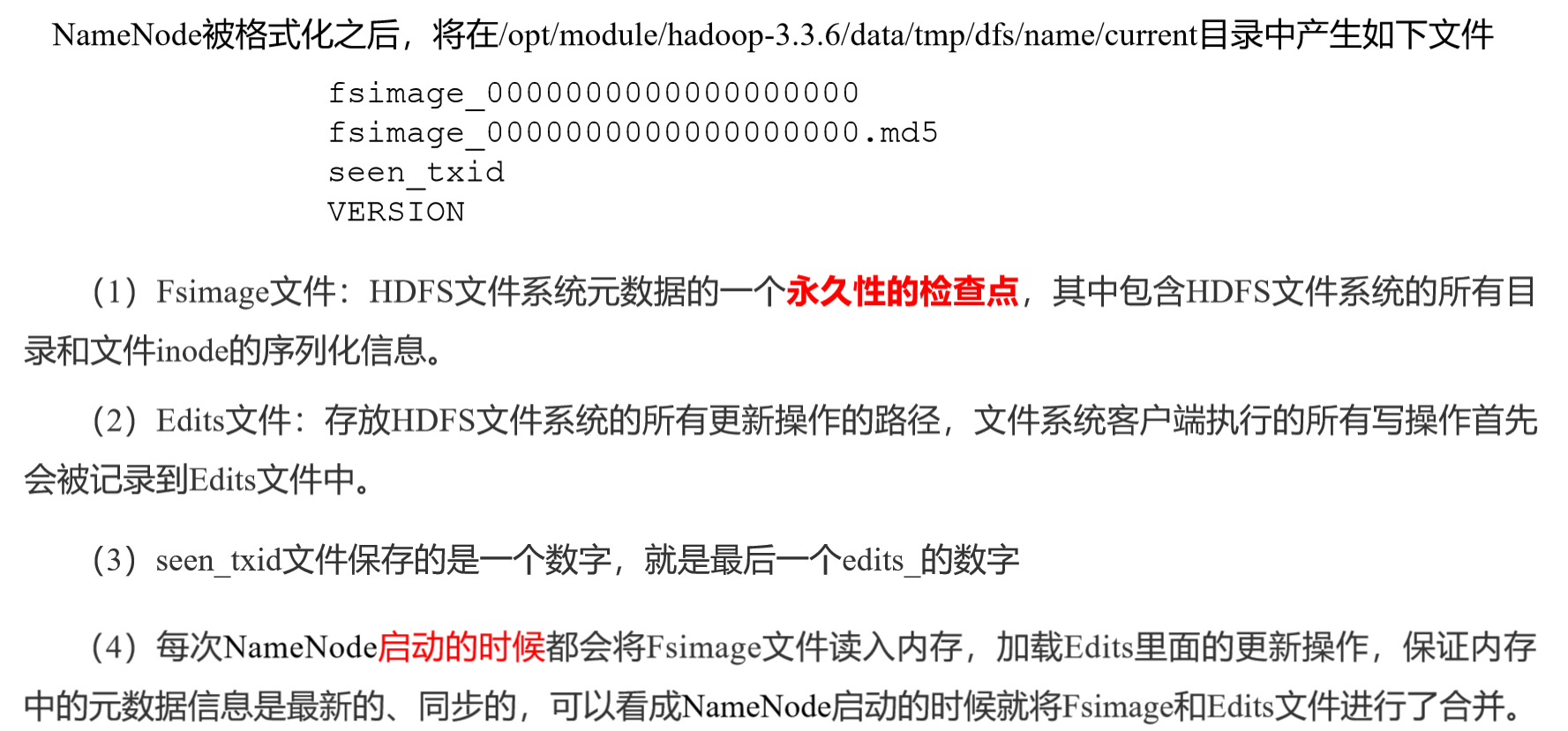

首先,我们做个假设,如果存储在NameNode节点的磁盘中,因为经常需要进行随机访问,还有响应客户请求,必然是效率过低。因此,元数据需要存放在内存中。但如果只存在内存中,一旦断电,元数据丢失,整个集群就无法工作了。因此产生在磁盘中备份元数据的FsImage。

这样又会带来新的问题,当在内存中的元数据更新时,如果同时更新FsImage,就会导致效率过低,但如果不更新,就会发生一致性问题,一旦NameNode节点断电,就会产生数据丢失。因此,引入Edits文件(只进行追加操作,效率很高)。每当元数据有更新或者添加元数据时,修改内存中的元数据并追加到Edits中。这样,一旦NameNode节点断电,可以通过FsImage和Edits的合并,合成元数据。

但是,如果长时间添加数据到Edits中,会导致该文件数据过大,效率降低,而且一旦断电,恢复元数据需要的时间过长。因此,需要定期进行FsImage和Edits的合并,如果这个操作由NameNode节点完成,又会效率过低。因此,引入一个新的节点SecondaryNamenode,专门用于FsImage和Edits的合并。

2. NameNode工作细节

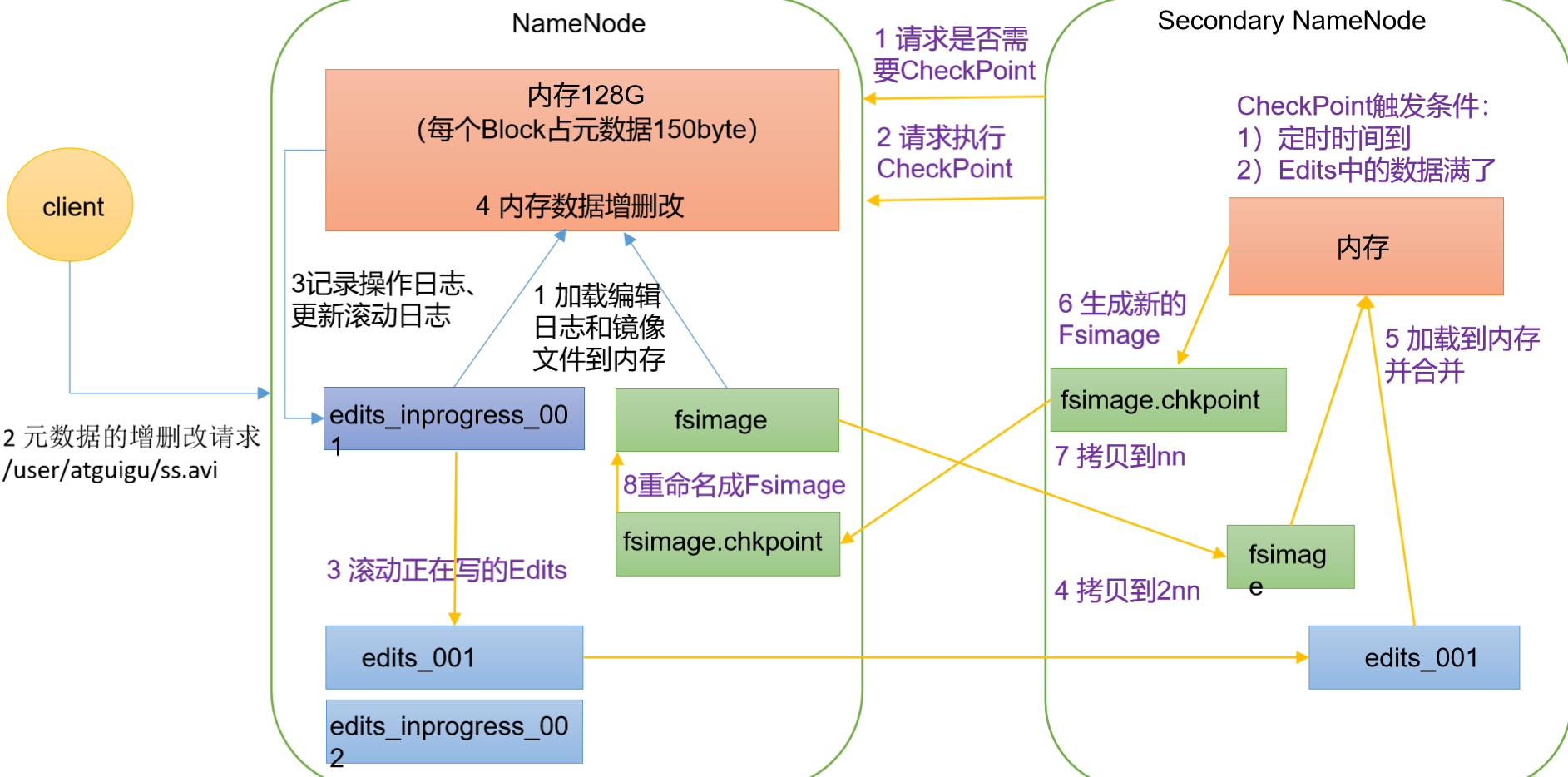

2.1 第一阶段:NameNode启动

(1)第一次启动NameNode格式化后,创建Fsimage和Edits文件。如果不是第一次启动,会直接加载编辑日志和镜像文件到内存中。

(2)客户端发起对元数据进行增删改的请求。

(3)NameNode记录操作日志在edits_inprogress_001中,更新滚动日志。

(4)NameNode在内存中对元数据进行增删改。

2.2 第二阶段:Secondary NameNode工作

(1)Secondary NameNode询问NameNode是否需要CheckPoint。返回NameNode是否检查结果。

(2)Secondary NameNode请求执行CheckPoint。

(3)NameNode将滚动正在写的Edits日志。

(4)将滚动前的编辑日志和镜像文件拷贝到Secondary NameNode。 (5)Secondary NameNode加载编辑日志和镜像文件到内存,并合并。

(6)生成新的镜像文件fsimage.chkpoint。 (7)拷贝fsimage.chkpoint到NameNode中。 (8)NameNode将fsimage.chkpoint重新命名成fsimage,做替换操作。

3. Fsimage和Edits解析流程

3.1 oiv手动查看Fsimage文件

oiv 查看解析fsimage文件命令

基本语法: hdfs oiv -p 文件类型 -i 镜像文件 -o 转换后文件输出路径

[jack@hadoop102 current]$ cd /opt/module/hadoop-3.3.6/data/dfs/name/current

[jack@hadoop102 current]$ hdfs oiv -p xml -i fsimage_0000000000000000702 -o /tmp/output/fsimage.xml查看fsimage.xml内容:

<INodeSection>

<lastInodeId>16541</lastInodeId>

<numInodes>78</numInodes>

<inode>

<id>16385</id>

<type>DIRECTORY</type>

<name></name>

<mtime>1705420929728</mtime>

<permission>jack:supergroup:0755</permission>

<nsquota>9223372036854775807</nsquota>

<dsquota>-1</dsquota>

</inode>

<inode>

<id>16386</id>

<type>DIRECTORY</type>

<name>user</name>

<mtime>1705372105341</mtime>

<permission>jack:supergroup:0755</permission>

<nsquota>-1</nsquota>

<dsquota>-1</dsquota>

</inode>

<inode>

<id>16387</id>

<type>DIRECTORY</type>

<name>jack</name>

<mtime>1705446160422</mtime>

<permission>jack:supergroup:0755</permission>

<nsquota>-1</nsquota>

<dsquota>-1</dsquota>

</inode>

<inode>

<id>16389</id>

<type>FILE</type>

<name>wc.input</name>

<replication>3</replication>

<mtime>1512722322219</mtime>

<atime>1512722321610</atime>

<perferredBlockSize>134217728</perferredBlockSize>

<permission>jack:supergroup:rw-r--r--</permission>

<blocks>

<block>

<id>1073741825</id>

<genstamp>1001</genstamp>

<numBytes>59</numBytes>

</block>

</blocks>

</inode>

....思考:可以看出,Fsimage中没有记录块所对应DataNode,为什么?

在集群启动后,要求DataNode上报数据块信息,并间隔一段时间后再次上报。

3.2 oev手动查看Edits文件

oev 查看解析edits文件命令

基本语法: hdfs oev -p 文件类型 -i 编辑日志 -o 转换后文件输出路径

[jack@hadoop102 current]$ hdfs oev -p xml -i edits_0000000000000000639-0000000000000000652 -o /tmp/output/edits.xml查看edits.xml里面内容:可以看出里面记录的主要是文件操作信息

<RECORD>

<OPCODE>OP_MKDIR</OPCODE>

<DATA>

<TXID>648</TXID>

<LENGTH>0</LENGTH>

<INODEID>16536</INODEID>

<PATH>/user/jack/input/story/bak</PATH>

<TIMESTAMP>1705418740292</TIMESTAMP>

<PERMISSION_STATUS>

<USERNAME>jack</USERNAME>

<GROUPNAME>supergroup</GROUPNAME>

<MODE>493</MODE>

</PERMISSION_STATUS>

</DATA>

</RECORD>

<RECORD>

<OPCODE>OP_RENAME_OLD</OPCODE>

<DATA>

<TXID>649</TXID>

<LENGTH>0</LENGTH>

<SRC>/user/jack/input/story/doupo.bak</SRC>

<DST>/user/jack/input/story/bak/doupo.bak</DST>

<TIMESTAMP>1705418801931</TIMESTAMP>

<RPC_CLIENTID>282436da-081d-4714-b14b-91df3fb390b8</RPC_CLIENTID>

<RPC_CALLID>3</RPC_CALLID>

</DATA>

</RECORD>

<RECORD>

<OPCODE>OP_DELETE</OPCODE>

<DATA>

<TXID>650</TXID>

<LENGTH>0</LENGTH>

<PATH>/user/jack/input/story/bak</PATH>

<TIMESTAMP>1705418872263</TIMESTAMP>

<RPC_CLIENTID>d4ac7d7a-3094-44f3-a2bc-e1c35dbd2ba6</RPC_CLIENTID>

<RPC_CALLID>3</RPC_CALLID>

</DATA>

</RECORD>

<RECORD>

<OPCODE>OP_SET_REPLICATION</OPCODE>

<DATA>

<TXID>651</TXID>

<PATH>/user/jack/input/story/doupo.txt</PATH>

<REPLICATION>10</REPLICATION>

</DATA>

</RECORD>

<RECORD>

<OPCODE>OP_END_LOG_SEGMENT</OPCODE>

<DATA>

<TXID>652</TXID>

</DATA>

</RECORD>

</EDITS>思考:NameNode如何确定下次开机启动的时候合并哪些Edits?

根据当前的fsimage的后缀名,合并大于后缀名的edits文件。

4. CheckPoint时间设置

通常情况下,SecondaryNameNode默认每隔一小时执行一次 查看[hdfs-default.xml]:

<property>

<name>dfs.namenode.checkpoint.period</name>

<value>3600s</value>

</property>一分钟检查一次操作次数,当edits文件里面操作次数记录达到1百万时,SecondaryNameNode执行一次

<property>

<name>dfs.namenode.checkpoint.txns</name>

<value>1000000</value>

<description>操作动作次数</description>

</property>

<property>

<name>dfs.namenode.checkpoint.check.period</name>

<value>60s</value>

<description> 1分钟检查一次操作次数</description>

</property>